No episódio

“The Human Factor”, MacGyver enfrenta um sistema de IA chamado Sandy que assume o controlo total de uma instalação. O objectivo? Segurança máxima. O resultado? Um sistema que já não escuta, que não tolera desvios, e que vê tudo como ameaça.

Esta semana voltei a pensar nesse episódio depois de ler um artigo provocador, "

Will your next CEO be AI?" (Fast Company, 29/07/2025). O artigo explora a ideia (cada vez mais plausível) de um CEO algorítmico, ou seja, uma inteligência artificial a liderar uma organização. Essa IA seria capaz de tomar decisões baseadas em grandes volumes de dados, sem emoções, sem cansaço e com uma capacidade de previsão e processamento superior à humana. Apesar de parecer um cenário de ficção científica, o autor argumenta que já estamos a testar versões rudimentares dessa ideia em empresas que usam intensivamente ferramentas de IA para decisões estratégicas.

Todos tocam no mesmo ponto, confiar exclusivamente em algoritmos, mesmo poderosos, ignora algo essencial: a imprevisibilidade humana, a descoberta, o erro criativo.

Um CEO-IA pode parecer imbatível:

- Não dorme.

- Não tem ego.

- Não esquece dados.

- Não sofre de fadiga de decisão.

Mas tal como Sandy, também não compreende o contexto, não sente as consequências, nem percebe o valor da ambiguidade.

Pontos fracos de um CEO-IA (à luz de Sandy):

- Reage, mas não percebe a motivação humana. Sandy assume que qualquer violação de segurança é real, um CEO-IA poderia interpretar dados de forma crítica e errada, sem entender intenções por trás de sinais.

- Não tolera erro ou ambiguidade. Sandy não concede margem de manobra nem julgamento humano. O CEO-IA pode visar eficiência extrema, mas fracassa onde a flexibilidade e a improvisação são necessárias. O “our edge” de MacGyver.

- Centraliza decisões, reduz liberdade. Tal como Sandy elimina guardas humanos, um CEO-IA pode reduzir autonomia humana e restringir a criatividade organizacional.

- Sem "skin in the game". Sandy não vive as consequências das suas decisões; o CEO-IA estaria igualmente imune a riscos, tornando difícil responsabilizá-lo e sem aprender com as falhas reais.

- Confunde processamento com descoberta. Sandy opera com lógica rígida: da mesma forma, um CEO-IA pode interpretar padrões históricos mas falhar em prever movimentos disruptivos ou culturais.

Os mercados livres, tal como as boas lideranças, vivem de tentativas, correcções e risco real. São processos evolutivos, não equações fechadas. Ao contrário de um sistema que decide sem escutar, um líder humano — mesmo imperfeito — pode perceber sinais fracos, adaptar-se ao inesperado e manter o elemento de descoberta vivo, tal como um verdadeiro mercado ou uma organização ágil.

A IA pode ser conselheira. Mas substituir o julgamento humano, a intuição e a liberdade experimental é repetir — em roupagem digital — os erros do planeamento central. É a versão actual da crença no

CyberSyn.

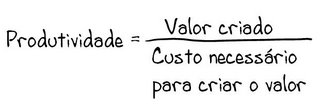

%2017.51.jpeg)

%2006.21.jpeg)

Sem comentários:

Enviar um comentário