terça-feira, setembro 22, 2015

"ao estilo poka-yoke"

.

Eu, recordei-me do primeiro caso de uso dos Métodos Taguchi! (parte I e parte II).

.

Os técnicos que estavam envolvidos no caso sabiam qual era a causa do problema (condutores); sabiam como resolver o problema (sugestões das caixas de comentários) mas não tinham recursos para o fazer. Por isso, optaram por outra abordagem:

.

Se não podemos mudar os condutores, mudemos o sistema. Mudemos as zonas onde ocorrem os pontos negros. Quais são as variáveis disponíveis que podem ser manipuladas ao estilo poka-yoke?

.

Há muitos anos, num posto de abastecimento de combustível, distraído, retirei o bocal do gasóleo para abastecer o meu carro que era a gasolina super. Então, aconteceu-me algo que nunca me tinha acontecido... o bocal não entrava na abertura do depósito do carro. Tentei e tentei outra vez. Só à terceira é que me concentrei e percebi que o bocal não entrava porque era o do gasóleo. Poka-yoke a funcionar.

segunda-feira, abril 07, 2008

Métodos Taguchi (parte II)

Existe ainda um outro método.

Usar matrizes ortogonais!

.

Uma matriz ortogonal é um design experimental construído para permitir uma avaliação matemática independente do efeito de cada um dos factores. O tipo de matriz que a empresa cerâmica (parte I) utilizou foi este:

Nesta matriz ortogonal existem 7 colunas e 8 linhas. Os factores são atribuídos às colunas . os níveis dos factores são indicados pelos números, 1 ou 2. Cada linha indica a combinação de níveis para cada factor a ser testada em cada experiência.

Nesta matriz ortogonal existem 7 colunas e 8 linhas. Os factores são atribuídos às colunas . os níveis dos factores são indicados pelos números, 1 ou 2. Cada linha indica a combinação de níveis para cada factor a ser testada em cada experiência.Por exemplo, na primeira linha, a experiência é feita com todos os factores no nível 1. Na terceira linha, a experiência é realizada com os factores A, D e E no nível 1 e os factores B, C, e G no nível 2.

Num design experimental ortogonal não estamos interessados no resultado de uma combinação em particular, mas na mudança média da resposta , ao longo de uma série de experiências. Isso vai-nos permitir fazer comparações entre os níveis 1 e 2, para cada factor.

O que Taguchi fez foi sistematizar um conjunto de matrizes ortogonais para que pudessem ser facilmente usadas na indústria.

A empresa cerâmica escolheu como variável y a estudar o número de peças defeituosas. A experiência 1 produziu 16 peças defeituosas de um total de 100 (16%). A experiência 4 produziu 6% de peças defeituosas e assim por diante como se ilustra a seguir:

Como o tamanho das amostras é sempre constante podemos trabalhar as percentagens como valores absolutos, assim:

Como o tamanho das amostras é sempre constante podemos trabalhar as percentagens como valores absolutos, assim:- Determinar a % total de peças defeituosas para cada factor e nível

Para A1: 16+17+12+6 = 51 ou seja em média A1 produz 51/4 = 12.75% de peças defeituosas

Para A2: 6+68+42+26 = 142 ou seja em média A2 produz 142/4 = 35.50% de peças defeituosas

Conclusão: o nível A1 é melhor que A2 - Calcular o efeito de cada factor para a média

Efeito do factor A: A2-A1 = (142 – 51)/4 = 91/4 = 22.75

Ou então, visto de forma gráfica:O factor que mais influencia a quantidade de peças defeituosas é o A, depois o F, depois o G e assim por diante.

- Determinar a melhor combinação de factores e níveis, neste caso a que minimize a quantidade de peças cerâmicas defeituosas:

A1, B2, C2, D1, E2, F1, G2

Se reparamos na diferença entre C1 e C2, podemos concluir que se usarmos uma receita com C1 e não com C2, a quantidade de peças defeituosas quase que não é alterada e a receita fica mais barata, assim a combinação escolhida foi:

A1, B2, C1, D1, E2, F1, G2

(continua)

sexta-feira, abril 04, 2008

Métodos Taguchi (parte I)

Como? Pode repetir!

E foi assim que cheguei aos métodos Taguchi! Depois, talvez em 1990, houve em Lisboa um curso sobre métodos Taguchi promovido pelo American Supplier Industry.

Como é que a coisa funciona:

"Em 1953 uma média empresa japonesa que fabricava peças cerâmicas, comprou um novo forno, a um fabricante da Alemanha Ocidental, por 2 milhões de dólares. O forno tinha cerca de 80 metros de comprimento. No seu interior, as peças cerâmicas empilhadas umas sobre as outras em vagões, circulavam lentamente sobre carris à medida que queimadores “coziam” as peças.

A empresa japonesa viu-se com um grave problema de qualidade, uma variabilidade excessiva na dimensão das peças. Descobriu que mais de 50% das peças do exterior da pilha excediam as especificações e que as peças do interior cumpriam a especificação com dificuldade.

.

É claro que os gestores e técnicos conheciam a causa da variação. A variação da temperatura no interior do forno causava a variabilidade nas dimensões das peças cerâmicas. Assim, a temperatura a que as peças cerâmicas eram sujeitas era o factor de perturbação do processo de cozimento.

Este problema poderia ser resolvido com o re-design do forno, para tornar a temperatura mais uniforme. Isto custaria cerca de meio milhão de dólares. Felizmente, em 1953 esta empresa não tinha os recursos suficientes para fazer tal investimento para reduzir a variabilidade. Assim, arranjaram outra forma de fazer descer a variabilidade dimensional das peças sem tornar a temperatura no interior do forno mais uniforme.

A empresa decidiu realizar experiências para investigar o efeito de vários factores do processo de fabrico de peças cerâmicas na dimensão das peças cerâmicas.

A empresa decidiu realizar experiências para investigar o efeito de vários factores do processo de fabrico de peças cerâmicas na dimensão das peças cerâmicas.Os técnicos da empresa identificaram factores no processo que pudessem ser manipulados de forma eficiente ao longo dessas experiências. Para cada factor resolveram testar diferentes níveis.

Para facilitar, vamos designar os factores como A, B, C, D, …, etc. e designar os diferentes níveis como A1, para o primeiro nível de A, A2, para o segundo nível de A, e assim por diante.

Neste caso, a decisão da empresa não foi, a de identificar e eliminar as causas da variação. A empresa conhecia a causa e sabia o quão cara ficaria a sua remoção. A sua abordagem foi a de procurar a melhor combinação dos factores, a combinação "óptima", para reduzir a variabilidade das peças cerâmicas.

.

Bah... eu aprendi a fazer isto desde a escola primária… 7 variáveis: manter 6 constantes e mudar uma delas. E depois repetir para outra variável e assim sucessivamente.

Vantagens deste método:

Vantagens deste método:- Poucas experiências

- Método simples e intuitivo (usado desde a escola primária)

- À medida que avançamos na realização das experiências vamos descobrindo coisas acerca do sistema

- Muito sensível a erros experimentais, para remediar usam-se mais amostras, ou seja, repetem-se os testes, o que aumenta o número de testes

- Ignora a interacção entre variáveis

- Leva a experiências pouco estruturadas

Convenhamos que na vida real as empresas têm mais que fazer do que andar a fazer experiências.

(continua)

terça-feira, abril 01, 2008

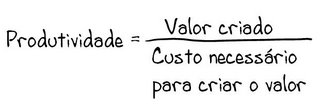

Mais conformidade é mais caro? E devia?

.

Por vezes, durante a execução das actividades incluídas nos processos das organizações, ocorrem defeitos, ocorrem falhas ou não-conformidades.

.

Essas falhas têm um custo associado, o chamado custo da não-qualidade, ou custo das falhas. Quanto mais falhas, maior o custo da não-qualidade. Quanto mais tarde se detectar a falha, maior o custo da não-qualidade. Por exemplo, uma falha detectada pelo cliente em sua casa pode implicar: custo de substituição do produto ou serviço; custo de transporte; custo da equipa que faz a substituição; custo da perca do cliente ou custo da indemnização; ou…

.

Assim:

.

.Atenção, qualidade neste contexto quer dizer: “ausência de defeitos”, ou “conformidade”, não quer dizer “mais atributos”.

.

Para reduzir o custo das falhas, para detectar as falhas mais cedo, as organizações aprenderam a dotar-se de actividades de controlo da qualidade, de verificação, de inspecção e ensaio. Essas actividades custam dinheiro, à sua soma pode dar-se o nome de custos de inspecção. E actividades de prevenção, como por exemplo a formação.

.

Quando a qualidade de um processo é má, e produz muitas falhas, um pequeno investimento no controlo da qualidade faz milagres, dá um retorno apreciável. À medida que o nível de qualidade melhora, para obter mais benefícios da inspecção há que investir mais e mais, como mostra a figura que se segue:

Custo das falhas, custo da prevenção (formação, manutenção preventiva,…), custo da inspecção, são tudo custos, é dinheiro.

Custo das falhas, custo da prevenção (formação, manutenção preventiva,…), custo da inspecção, são tudo custos, é dinheiro..

Então, podemos somar esse dinheiro e obter a curva do custo de garantir a qualidade:

Ou seja, existe um custo óptimo:

Ou seja, existe um custo óptimo: Para o exemplo concreto da figura, procurar investir em aumentar o controlo e a prevenção acima dos 98% é possível mas fica muito caro e não compensa.

Para o exemplo concreto da figura, procurar investir em aumentar o controlo e a prevenção acima dos 98% é possível mas fica muito caro e não compensa.Assim, criou-se uma cultura em que mais qualidade é mais caro!

Assim, criou-se uma cultura em que o cliente aceita correr o risco de receber algum produto defeituoso, porque exigir do fornecedor um risco zero implicaria um aumento dos custos de garantia da qualidade, como se pode demonstrar pela figura.

.

Assim, criámos normas de amostragem como a ISO 2859. Aqui, por exemplo, podemos verificar que para um lote com 281 a 500 unidades, para um nível de qualidade aceitável (AQL) de 2.5% (o lote tem no máximo 2.5% de peças defeituosas) se analisarmos uma amostra com 20 peças, se aparecerem pelo menos duas defeituosas o lote deve ser rejeitado, se não aparecer mais do que uma peça defeituosa o lote pode ser aceite.

Vivemos alegres e felizes neste paradigma até que…

.

Há um mito urbano que ouvi contar pela primeira vez numa sessão em que estava a ser praxado durante o meu primeiro ano na universidade (talvez no último trimestre de 1982), que exemplifica como é que este mundo começou a ruir (os números foram inventados por mim aqui e agora):

.

Uma empresa americana encomendou parafusos a uma empresa japonesa, por exemplo, 10 milhões de parafusos e estipulou que queria um AQL de 0.01%.

Os japoneses na volta do correio mandaram a encomenda de 10 milhões de parafusos, afirmando que estavam todos bons. Enviaram também uma caixa mais pequena com 1000 parafusos defeituosos acompanhados de uma carta dizendo: “Pediram 10 milhões de parafusos que enviamos na caixa principal. Pediram também 1000 parafusos defeituosos, não sabemos para que os querem, mas eles aqui vão na caixa mais pequena.”

Como é que isto era possível?

Como é que era possível conciliar 100% de produto conformes com custos de garantia da qualidade finitos e competitivos?

.

Para os japoneses a curva da garantia da qualidade era outra:

Como? Porquê?

Como? Porquê?.

Em vez de pactuarem com processos incapazes que produziam defeitos que depois eram detectados (quando eram) e corrigidos ou sucatados, recorreram a uma abordagem diferente: “Don’t blame the product, blame the process”.

.

Aperfeiçoar os processos, tornar mais difícil que a falha volte a ocorrer no futuro, como dizia Taguchi “enrobustecer os processos”, sem ser à custa de mais controlo, mais gastos, mais despesa.

.

Era neste contexto que se utilizavam as clássicas sete ferramentas da qualidade (como as sete armas de um samurai) que gerações de pessoas da qualidade em todo o mundo ocidental conheceram através desta relíquia da autoria de Kaoru Ishikawa publicada em 1971 “Guide to Quality Control”.

.

Lembrei-me destas estórias da evolução da Qualidade por causa destas notícias:

“Multas ficam por cobrar” no Correio da manhã, assinado por Miguel Curado e Eduardo Dâmaso e “Milhares de multas podem prescrever hoje” no Portugal Diário.

.

Há uma falha, a prescrição de multas. Em vez de estudar o processo, em vez de perceber o que é que falha no processo, aumenta-se o controlo, aumentam-se os custos de inspecção.

Desde o acto de multar o condutor até à emissão do recibo do pagamento da multa, quantas etapas temos?

.

Por exemplo: 10 etapas.

.

Factualmente, quanto tempo demoramos, em média, a processar uma multa em cada etapa?

Factualmente, quais são as duas etapas onde as multas “encalham”? (um diagrama de Pareto ajuda)

Agora, em cada uma dessas etapas críticas, especulemos: “Porque demoramos tanto tempo a processar as multas?” (um diagrama de causa-efeito, ou uma CRT ajuda). Qual ou quais são as causas-raiz?

Segue-se a mudança do processo de forma a eliminar, ou reduzir, a ocorrência das causas-raiz que geram o nível de desempenho actual.

.

Mas quem fala em multas, podia também falar na redução dos tempos de espera para cirurgia, na redução da prescrição do pagamento de impostos, na redução de desperdícios de medicamentos, na…

A continuar assim, na Administração Pública, mais qualidade, no sentido de maior conformidade, de menos falhas significa mais caro… ao contrário do que dizia Crosby.

segunda-feira, setembro 10, 2007

Custos e Preços vs Variabilidade e Especificações

Limite Superior da Especificação = Média + o desvio padrão

Limite Inferior da Especificação = Média - o desvio padrão

Perante esta fórmula, lembrei-me logo da relação entre o Preço e o Custo.

Assim como não há relação matemática entre o Preço e o Custo, também não há relação matemática entre Especificação e Variabilidade (desvio padrão - o sigma).

O preço praticado por uma empresa é sempre o maior possível, é aquele que o mercado permitir. Se o preço não for suficiente, para compensar os custos, a empresa acumula prejuízos e tem de fechar.

Uma das parvoíces que praticava, quando era um jovem responsável pelo departamento da qualidade, na empresa onde trabalhava, consistia em defender e promover a publicação de especificações muito apertadas, para os nossos produtos.

“Vejam como somos bons, somos tão bons que conseguimos apresentar estas especificações super apertadas.”

Hoje, partilho de uma opinião quase oposta. As nossas especificações devem ser tão alargadas quanto o mercado o permitir. Se o mercado premiar especificações mais apertadas, então devemos publicá-las mais apertadas, se o mercado não valorizar isso, para quê a auto-imposição de um colete-de-forças?

A relação entre especificações e variabilidade é semelhante à relação entre o preço e o custo… nenhuma.

As especificações são definidas por legislação, ou pelo mercado. Mesmo quando uma empresa especifica que a densidade do seu produto tem um valor nominal de x, e um limite superior de especificação de y e, um limite inferior de z, deve fazê-lo tendo em atenção o mercado, o interesse dos clientes e a oferta da concorrência.

A variabilidade de um processo pode ser maior, ou menor.

Quanto mais variabilidade, mais dispersão, maior o desvio padrão (o sigma).

Quando a distribuição dos resultados de um processo segue uma distribuição normal, podemos afirmar que:

Ou seja:

Ou seja:Cerca de 68,4% dos resultados estão entre a média menos uma vez o desvio padrão e a média mais uma vez o desvio padrão;

Cerca de 95,4% dos resultados estão entre a média menos duas vezes o desvio padrão e a média mais duas vezes o desvio padrão; e

Cerca de 99,7% dos resultados estão entre a média menos três vezes o desvio padrão e a média mais três vezes o desvio padrão.

A empresa que publicou as especificações apresentadas no início deste postal, não as pode cumprir, é impossível.

È impossível porque seria muito caro, se a empresa tiver uma média de resultados semelhante ao valor nominal da especificação, automaticamente tem de descartar como refugo, ou 2ª qualidade, cerca de 32% do que produz (tudo o que se afasta mais de ± uma vez o desvio padrão em torno da média).

No entanto, tal como entre preço e custo, convém que a especificação seja mais alargada que a distribuição normal dos resultados do processo.

Assim, toda a produção é vendável como primeira escolha.

Assim, toda a produção é vendável como primeira escolha.Quanto mais apertadas as especificações, face à variabilidade do processo, maior o risco de produzir produto não-conforme:

Daí o uso, em processos que estão sob controlo estatístico, e só nesses, da variável capacidade do processo, para medir até que ponto o processo tem capacidade de cumprir as especificações.

Daí o uso, em processos que estão sob controlo estatístico, e só nesses, da variável capacidade do processo, para medir até que ponto o processo tem capacidade de cumprir as especificações.As especificações são um artifício útil para regular as trocas comerciais, no entanto, há que não esquecer o que Taguchi escreveu sobre a variabilidade, e sobre as especificações. Mais importante do que cumprir as especificações, é o reduzir a variabilidade.